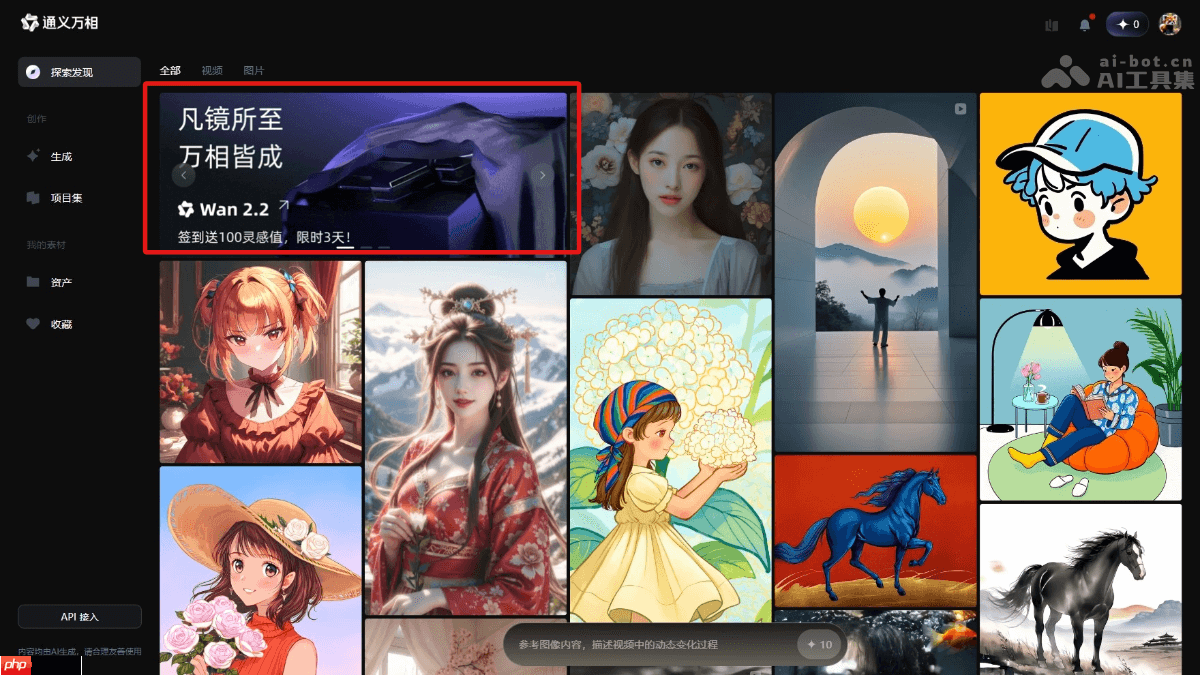

通义万相2.2— 阿里开源的AI视频生成模型

时间:2025-07-29 作者:游乐小编

通义万相2.2是什么

通义万相2.2(Wan2.2)是阿里巴巴推出的全新开源AI视频生成模型,标志着视频生成技术的又一次重大突破。此次共发布三款模型:文生视频(Wan2.2-T2V-A14B)、图生视频(Wan2.2-I2V-A14B)以及统一视频生成模型(Wan2.2-IT2V-5B),总参数规模高达270亿。该系列首次采用混合专家(MoE)架构,在提升生成质量的同时优化了计算效率。更值得一提的是,其创新性地引入了电影级美学控制系统,可精准调控光影、色彩、构图等视觉元素,实现专业级视频输出。其中,5B参数的紧凑型统一生成模型支持文本与图像联合驱动视频生成,基于高效3D VAE架构,能够在消费级GPU上流畅运行,实现高速生成高清视频的能力。目前,开发者可通过GitHub、HuggingFace等平台获取完整模型与代码,企业用户可借助阿里云百炼平台调用API进行集成开发,普通用户则可在通义万相正式及通义APP中直接体验强大功能。

通义万相2.2的核心功能

通义万相2.2的核心功能

- 文本生成视频(Text-to-Video):只需输入一段文字描述,如“一只猫在草地上奔跑”,模型即可自动生成符合语义的动态视频内容。

- 图像生成视频(Image-to-Video):上传静态图片后,模型能够理解画面内容并生成连贯的动态场景,让静态图像“动起来”。

- 图文联合生成视频(Text-Image-to-Video):结合文本提示与输入图像,实现更精确的内容控制和情节表达,提升生成视频的相关性与表现力。

- 电影级美学调控系统:支持通过关键词输入(如“冷色调”“对称构图”“柔光效果”)调节视频的艺术风格,生成具备专业影视质感的视觉作品。

- 复杂动作与交互建模:能够生成包含人物互动、复杂运动轨迹和多对象协同的动态场景,显著增强视频的真实感与叙事能力。

通义万相2.2的技术亮点

- 混合专家(MoE)架构创新:将模型划分为高噪声专家与低噪声专家,前者负责整体结构布局,后者专注于细节优化。在不增加计算开销的前提下,显著提升模型容量与生成质量。

- 扩散模型为基础框架:以扩散机制为核心生成逻辑,通过逐步去噪过程构建高质量视频帧序列,结合MoE结构进一步提升生成稳定性与细节还原度。

- 高压缩比3D变分自编码器(VAE):采用专为视频设计的3D VAE架构,实现空间与时间维度的高效压缩,降低显存占用,使高清视频生成可在消费级显卡上快速完成。

- 大规模多模态训练数据:依托海量图文与视频数据进行训练,涵盖多样场景与风格,增强模型的泛化能力与内容适应性。

- 精细化美学标注体系:引入专业级美学标签数据(如光影层次、色彩搭配、镜头语言等),使模型具备对艺术风格的理解与控制能力,满足高端视觉创作需求。

通义万相2.2的开源地址

- GitHub项目主页:https://www.php.cn/link/7c3349793d7221d1d89a6f9853009048

- HuggingFace模型仓库:https://www.php.cn/link/28b666d0bbf15152aca966add171113d

如何使用通义万相2.2

- 访问最新平台:前往通义万相正式或下载通义APP,即可开始体验AI视频生成能力。

- 选择对应模型:在界面中选择“通义万相2.2”版本,并根据需求切换不同生成模式。

- 选择生成方式:

- 文生视频:输入描述性文本(如“夕阳下海浪拍打礁石”),点击生成,系统将输出匹配的视频片段。

- 图生视频:上传一张图片,模型将基于图像内容生成具有动感的短视频。

- 图文联合生成:同时提供图片与文字说明,获得更准确、更具情境感的视频输出。

- 参数自定义(可选):可调整视频分辨率、帧率等基础参数,并通过美学控制系统输入风格关键词(如“赛博朋克风”“慢动作”),定制专属视觉效果。

- 查看与分享结果:生成完成后,视频将实时预览,用户可直接下载或分享至社交平台。

通义万相2.2的应用前景

- 短视频内容生产:助力创作者快速生成高质量短视频,适用于抖音、快手、小红书等平台,大幅提升内容产出效率。

- 品牌营销与广告制作:为品牌方和广告公司提供低成本、高效率的视频广告生成方案,强化传播效果。

- 教育培训可视化:帮助教育机构将抽象知识转化为生动动画,提升学习兴趣与理解深度。

- 影视前期创作辅助:可用于概念设计、分镜预演、动画草稿生成,加速影视项目开发流程。

- 新闻与媒体内容增强:支持新闻报道中的动态图解与视觉还原,增强信息传达力与观众沉浸感。

小编推荐:

热门推荐

更多 热门文章

更多 -

- 神角技巧试炼岛高级宝箱在什么位置

-

2021-11-05 11:52

手游攻略

-

- 王者荣耀音乐扭蛋机活动内容奖励详解

-

2021-11-19 18:38

手游攻略

-

- 坎公骑冠剑11

-

2021-10-31 23:18

手游攻略

-

- 原神卡肉是什么意思

-

2022-06-03 14:46

游戏资讯

-

- 《臭作》之100%全完整攻略

-

2025-06-28 12:37

单机攻略