CMU15-445 数据库系统播客:分布式数据库简介 - 共享无关、分区与分布式事务

理想情况下,这个中间件层对应用开发者是透明的。开发者编写的 SQL 仿佛是在操作一个单一的、巨大的逻辑数据库,而无需关心数据具体存储在哪个物理分片上。

数据量呈指数级增长的今天,传统的单体数据库在存储容量、并发处理能力和可用性方面都面临着巨大挑战。分布式数据库应运而生,它通过将数据和计算负载分散到多台独立的机器上,实现了近乎无限的水平扩展能力。然而,这种“分而治之”的策略也引入了前所未有的复杂性。

本文将以 CMU 数据库课程的知识为蓝本,带您深入探索分布式数据库的核心世界,从系统架构、数据分区策略,到最棘手的分布式事务,逐一揭开其神秘面纱。

正本清源:并行数据库 vs. 分布式数据库

在深入探讨之前,我们必须先厘清两个经常被混淆的概念:并行数据库和分布式数据库。它们的核心区别在于对底层硬件和网络环境的假设。

并行数据库系统 (Parallel DBMSs)

环境: 通常运行在单一、紧密耦合的硬件上,比如一台拥有多个 CPU、共享内存和磁盘的多核服务器。节点间的通信通过高速、可靠的内部总线(Interconnect)进行。核心假设: 节点间通信成本低、速度快、几乎不会失败。因此,系统设计可以不必过多考虑网络分区、消息丢失或节点宕机等问题。其主要目标是利用并行化来加速复杂查询的处理。分布式数据库系统 (Distributed DBMSs)

环境: 运行在由多台独立、松散耦合的机器组成的集群上,这些机器通过标准网络(局域网或广域网)连接,可能分布在不同机架、不同数据中心甚至不同地理位置。核心假设: 网络是不可靠且有延迟的。节点随时可能崩溃,消息可能丢失或延迟。因此,通信成本和容错机制是系统设计的核心考量。分布式环境下的任何操作都比单机环境要复杂和昂贵得多。简而言之,并行数据库关心的是“如何利用多核多处理器更快地完成任务”,而分布式数据库的核心则是“如何在不可靠的硬件和网络上构建一个可靠、可扩展的系统”。

两大基石:分布式系统架构

分布式数据库的系统架构决定了数据如何存储、CPU 如何协同工作。主流架构主要分为两种:共享磁盘(Shared Disk)和共享无关(Shared Nothing)。

共享磁盘 (Shared Disk)

在这种架构中,所有计算节点(CPU)拥有各自独立的私有内存,但它们共享同一个逻辑存储层,可以通过高速网络访问所有数据。现代云数据库中的对象存储(如 Amazon S3)或分布式文件系统就是典型的共享存储层。

优势:

计算与存储分离: 计算层和存储层可以独立、弹性地进行扩展。当需要更强的计算能力时,只需增加计算节点;当存储空间不足时,只需扩展存储层,两者互不影响。高可用性与快速恢复: 计算节点是“无状态”的,因为所有持久化的数据库状态都保存在共享存储中。一个计算节点宕机后,可以迅速启动一个新的节点来接替其工作,而不会丢失数据。简化数据迁移: 由于数据集中存储,增加或减少计算节点时无需进行大规模的数据物理迁移。挑战:

缓存一致性 (Cache Coherence): 这是最大的挑战。当节点 A 修改了某份数据并写回共享存储后,节点 B 本地缓存中的相同数据并不会自动失效。系统必须引入额外的协调机制(如节点间的消息传递或分布式锁)来通知其他节点“数据已更新”,以防止读取到过期数据。分布式锁管理: 为保证数据一致性,需要一个全局的分布式锁管理器(Distributed Lock Manager, DLM)来协调节点间的并发访问,这可能成为系统的性能瓶颈。数据访问延迟: 查询所需的数据通常需要从共享存储远程拉取到计算节点的本地内存中进行处理,网络延迟会影响性能。典型代表: Snowflake, Amazon Aurora, Oracle RAC。共享无关 (Shared Nothing)

这是最经典也是最普遍的分布式数据库架构。每个节点都是一个自给自足的“小王国”,拥有自己独立的 CPU、内存和磁盘。节点之间没有任何共享资源,所有通信都必须通过网络进行。一个节点不能直接访问另一个节点的内存或磁盘。

优势:

优异的可扩展性: 由于没有共享资源成为瓶颈,可以通过简单地增加节点来线性地扩展系统的整体性能和容量。高数据局部性: 如果查询能被限定在单个节点内完成,其性能几乎与单机数据库无异,因为它避免了昂贵的网络数据传输。挑战:

扩容与数据再平衡 (Rebalancing): 这是共享无关架构的“阿喀琉斯之踵”。当增加新节点时,为了实现负载均衡,必须从现有节点上物理地迁移部分数据到新节点。这个过程非常复杂,必须在不影响在线服务和保证事务一致性的前提下进行,技术挑战巨大。分布式查询与事务: 跨多个节点的查询和事务需要复杂的协调协议来保证结果的正确性和数据的一致性。典型代表: Google Spanner, Cassandra, CockroachDB, TiDB。

数据该放哪?分区、透明性与一致性哈希

在分布式系统中,如何将庞大的数据集拆分并均匀地分布到各个节点上,同时让应用程序对此过程无感,是设计的关键。

数据分区 (Partitioning / Sharding)

数据分区(在 NoSQL 领域常被称为“分片”)是将一个大表或数据库分解成更小、更易于管理的部分的过程。最常见的分区方式是水平分区,即根据分区键 (Partitioning Key)的值将表中的行(元组)分配到不同的分区。

哈希分区 (Hash Partitioning)

原理: 对分区键的值应用哈希函数,然后根据哈希结果(通常是取模运算)决定数据存储在哪个分区。优点: 能非常均匀地分散数据和负载,适合等值查询(如WHERE user_id = ?)。缺点:不适合范围查询: 范围查询(如WHERE age BETWEEN 20 AND 30)会退化为全部分区扫描,效率极低。

扩容灾难: 当分区数量(节点数)改变时,模数发生变化,几乎所有数据都需要根据新的哈希规则重新计算和迁移,这个过程成本极高。

范围分区 (Range Partitioning)

原理: 根据分区键的取值范围来划分数据。例如,用户 ID 1-1000 在分区 1,1001-2000 在分区 2。优点: 非常适合范围查询,因为相关数据物理上是聚集在一起的。缺点: 容易导致数据和负载不均,产生“热点”问题。例如,如果新注册用户 ID 总是递增的,那么所有写入请求都会集中在最后一个分区。一致性哈希:优雅地解决扩容难题

为了解决传统哈希分区在扩容时的“数据大迁徙”问题,一致性哈希 (Consistent Hashing)技术应运而生。

核心思想: 它将哈希函数的输出空间(例如到)想象成一个闭环的“环”。每个分区节点和每条数据都通过哈希计算被映射到这个环上的一个点。数据定位: 要确定一条数据属于哪个节点,先将它的键哈希到环上,然后顺时针方向寻找遇到的第一个节点,该节点即为负责存储这条数据的节点。扩容的魔力: 当集群中新增一个节点 D时,它被映射到环上的某个位置。此时,只有它顺时针方向的下一个节点(假设为 C)需要将自己管理的一部分数据(哈希值在 D 和 C 之间的数据)迁移给新节点 D。环上其他所有节点的数据分布完全不受影响!这极大地降低了扩容和缩容时的数据迁移成本。一致性哈希是 DynamoDB、Cassandra、Riak 等众多分布式系统的核心技术之一。

数据透明性 (Data Transparency)

理想的分布式数据库应该对上层应用隐藏其底层的复杂性。数据透明性意味着应用程序无需关心数据具体存储在哪个物理节点,也无需知道表是如何被分区的。一个在单机数据库上能正常运行的 SQL 查询,在分布式环境中也应该能无缝执行并返回相同的结果。

为实现这一点,系统通常会有一个查询路由层 (Query Router)或中间件。它维护着数据分区规则的元数据,当接收到查询时,它会解析查询,确定所需数据位于哪些节点,然后将请求转发给相应的节点,最后汇总结果返回给客户端。MongoDB 的mongos就是一个典型的查询路由器。

终极挑战:分布式事务

如果说数据分区是分布式数据库的“骨架”,那么分布式事务就是其“灵魂”,也是实现起来最困难、最昂贵的部分。

一个分布式事务可能需要读取和修改分布在多个节点上的数据。要保证其ACID特性,尤其是原子性 (Atomicity)和持久性 (Durability),系统必须确保事务的所有操作要么在所有节点上全部成功提交,要么全部失败回滚。

为什么如此困难?

节点故障: 任何一个参与事务的节点都可能在事务执行的任意时刻崩溃。网络分区: 节点间的网络连接可能中断,导致它们无法通信。原子提交的困境: 协调器需要一种协议来确保所有参与节点对事务的最终结果(提交或中止)达成共识。最经典的协议是两阶段提交 (Two-Phase Commit, 2PC)。准备阶段 (Prepare Phase): 协调器向所有参与节点发送“准备”请求。节点收到后,执行事务操作,将 redo 和 undo 日志写入磁盘,然后锁定相关资源,并向协调器回复“准备好了”或“失败”。提交阶段 (Commit Phase):如果协调器收到所有参与节点的“准备好了”响应,它就向所有节点发送“提交”指令。如果任何一个节点回复“失败”或超时,协调器就向所有节点发送“中止”指令。2PC 的致命缺陷: 2PC 是一个阻塞协议。如果在准备阶段后、提交阶段前,协调器宕机,所有参与节点将进入不确定状态,它们不知道该提交还是回滚,只能一直持有锁并等待协调器恢复,从而导致整个系统停滞。分布式死锁: 多个事务在不同节点上相互等待对方持有的锁,形成一个难以检测的循环等待。为了验证分布式系统在这些极端情况下的健壮性,Kyle Kingsbury 的Jepsen项目通过模拟各种网络分区和节点故障,对市面上几乎所有的主流分布式数据库进行了“酷刑测试”,揭示了许多系统在一致性和容错性方面存在的理论与现实之间的差距。

总结

从单体走向分布式,数据库系统完成了一次巨大的飞跃,以应对现代应用的规模化需求。然而,这并非一蹴而就的银弹。

共享磁盘架构通过解耦计算和存储,提供了极佳的弹性和可用性,但在缓存一致性和锁管理上付出了代价。共享无关架构提供了极致的水平扩展能力,但在数据再平衡和分布式协调方面面临巨大挑战。从哈希分区到一致性哈希,我们看到了工程师们为解决扩容难题所展现的卓越智慧。而分布式事务,作为分布式系统领域的“圣杯”,至今仍是衡量一个数据库系统成熟度和可靠性的终极试金石。理解这些核心概念、架构选择及其背后的权衡,不仅能帮助我们更好地选择和使用合适的数据库产品,更能让我们对构建大规模、高可用的后台服务有更深刻的认识。分布式系统的世界,充满了挑战,也同样充满了机遇。

拓展: MySQL 分区方案

与 Google Spanner 或 TiDB 这类原生分布式数据库不同,MySQL 本身并不具备自动分区、查询路由和分布式事务协调的能力。因此,为了实现水平扩展,企业通常不会替换掉稳定且生态成熟的 MySQL,而是在其之上构建了一套解决方案。这种方案的核心,就是在应用层和数据库层之间引入一个数据库中间件 (Database Middleware)层。

这个模型的工作方式如下:

物理上的共享无关:在物理层面,数据库被拆分成成百上千个独立的 MySQL 实例,每个实例(即一个“分片”或 Shard)都部署在独立的服务器上,拥有自己的 CPU、内存和磁盘。它们之间不共享任何资源,完全符合“共享无关”的定义。

中间件实现逻辑统一:这个中间件层是实现“分布式”能力的关键。它对上层应用程序扮演着一个“超级数据库”的角色,负责:

查询路由:中间件会解析应用程序的 SQL 请求,根据预设好的分区键(Sharding Key,例如user_id或order_id)和分区规则(通常是哈希取模),精确地将查询路由到存储目标数据的那个 MySQL 分片上。对于大部分点查和基于分区键的查询,这非常高效。结果聚合 (Scatter-Gather):如果一个查询无法通过分区键定位(例如,一个不带user_id条件的后台统计查询),中间件会将该查询“广播”到所有相关的分片上执行,然后将从各分片返回的部分结果在中间件层进行合并、排序或聚合,最后将最终结果返回给应用。分布式事务支持 (有限的):对于必须跨分片的事务,中间件会尝试扮演事务协调者的角色,通过两阶段提交(2PC)或最终一致性的方案(如TCC、Saga)来保证原子性,但这通常非常复杂且性能开销大,在设计时会尽量避免。对应用的透明性:理想情况下,这个中间件层对应用开发者是透明的。开发者编写的 SQL 仿佛是在操作一个单一的、巨大的逻辑数据库,而无需关心数据具体存储在哪个物理分片上。

业界有很多成熟的开源中间件来实现这一层,例如由 YouTube 开创并贡献给 CNCF 的Vitess,以及 Apache 基金会的顶级项目ShardingSphere等。

总结来说,这个方案就是通过在应用和数据库之间增加一个智能代理层,将一组独立的 MySQL 实例“粘合”成一个逻辑上统一、物理上分散的共享无关集群。这使得企业能够在继续享受 MySQL 生态成熟、稳定可靠的红利的同时,获得应对海量数据和高并发访问所需的强大水平扩展能力。

相关攻略

在 NVIDIA GTC 2024 大会上,黄仁勋官宣了和 Milvus 项目合作,Zilliz 被三次邀请上台演讲;大会三天之后,OpenAI 官宣和 Zilliz 合作,在发布的 chatgpt

具有实际生产经验的人会发现MySQL等数据库部署在容器了会出现很多问题。主要从下面几点展开讲。 今天分享一个高频面试题:为什么不推荐在生产环境中将 MySQL 部署在容器里?这个问题的出现首先肯定的

随着云原生架构和开放数据格式的普及,现代 OLAP 系统正变得前所未有的强大、灵活和经济高效。无论是商业巨头 Snowflake、Redshift,还是开源新星 ClickHouse、DuckDB,

一个优秀的数据库系统会智能地运用这些算法。这正是 SQL 这种声明式语言的强大之处:用户只需描述“需要什么”,而无需关心“如何获取”,底层的数据库系统会负责选择最高效的路径来执行查询。 在关系型数据

为了满足这一需求,数据库技术必须进化。传统磁盘数据库的 I O 瓶颈使其难以胜任, 内存数据库(In-Memory Database) 因此应运而生,成为推动这场变革的核心技术。 需求:实时企业的速

热门专题

热门推荐

一款名为OpenAgents的开源项目近期引发技术圈热议。该项目致力于构建开放协作的智能体网络,被部分开发者誉为 "年度最具潜力的Agent生态框架 ",同时也面临 "技术泡沫 "的质疑。其核心目标是通过网

当豪华中大型车市场的竞争进入白热化阶段,2026款奔驰E级以“全能选手”的姿态闯入视野。这款车不再让消费者在性能、能耗与智能之间做艰难抉择,而是将三大核心诉求融为一体,试图重新定义“豪华车标杆”的衡

近日,一则来自吉林长春的航天消息引发关注——由长光卫星技术股份有限公司与国网电力工程研究院有限公司联合研制的“电力工程号A星”(“吉星”高分07A01星)正式从吉林省航天信息产业园启程,即将奔赴酒泉

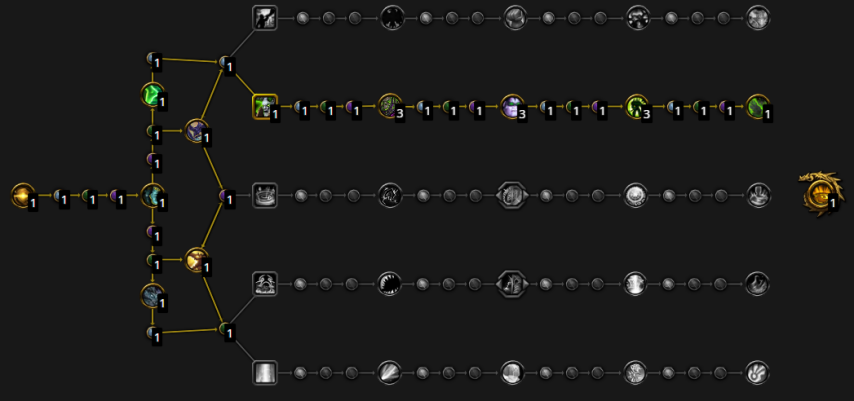

魔兽世界幻境新生是《魔兽世界》最近上线的限时季度活动,允许玩家以时空奔行者身份重新体验“军团再临”资料片,那么有不少小伙伴好奇幻境新生防战天赋加点怎么点,下面就来告诉大家防战天赋代

10月10日至12日,2025中国移动全球合作伙伴大会在广州琶洲保利世贸展馆举行。本届大会以“碳硅共生合创AI+时代”为主题,汇聚了来自通信、终端、汽车、AI、能源等多个领域的数百家合作伙伴。作为中