基于Paddle工具链:ROS目标检测部署方案

时间:2025-07-24 作者:游乐小编

FSACOCO数据集由北理工无人驾驶方程式车队搭建,用于中国大学生无人驾驶赛事视觉部分,含42张带标注的红蓝锥桶图像。介绍了两种基于飞桨的训练方式:PaddleDetection需克隆仓库、改参数等,PPYOLO v2训练后mAP50达99.01%;PaddleX则通过低代码完成全流程。两者均涉及模型导出与部署,可参考BITFSD开源3.0。

数据集介绍

FSACOCO 数据集由 北京理工大学无人驾驶方程式车队 进行搭建并维护,致力于中国大学生无人驾驶方程式赛事中视觉部分的应用,该项赛事使用红蓝锥桶代表赛道边界,参赛队伍需要在未知地图的条件下得到最快圈时,同类数据集可参考FSOCO ,由苏黎世联邦理工学院AMZ车队进行维护,为德国大学生无人驾驶方程式大赛视觉部分数据集。

此项目作为北京理工大学无人驾驶方程式车队FSD开源3.0中目标检测模块进行展示

解压数据集

数据集格式:

-dataset_sample

|-Annotations

|-0.xml

|-1.xml

|-10.xml

|-...

|-JPEGImage

|-0.jpg

|-1.jpg

|-10.jpg

|-...

|-eval.txt

|-labels.txt

|-train.txt

注: 此处仅提供42张数据

更多数据集可以前往https://github.com/bitfsd/FSACOCO获取

!unzip data/data126556/dataset_sample.zip -d ./dataset_sample登录后复制

方式一

使用PaddleDetection训练

PaddleDetection为基于飞桨PaddlePaddle的端到端目标检测套件,提供多种主流目标检测、实例分割、跟踪、关键点检测算法,配置化的网络模块组件、数据增强策略、损失函数等,推出多种服务器端和移动端工业级SOTA模型,并集成了模型压缩和跨平台高性能部署能力,帮助开发者更快更好完成端到端全开发流程。

特性

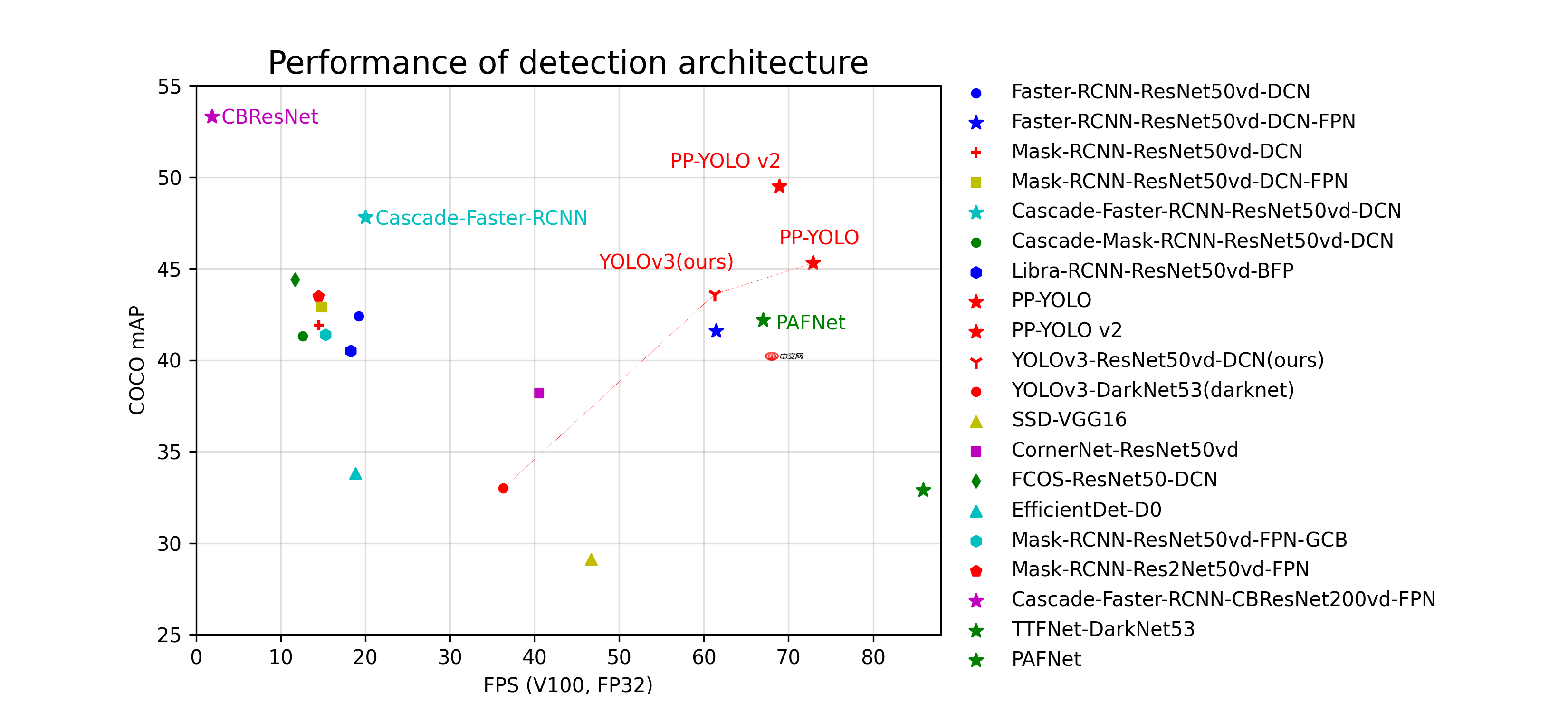

模型丰富: 包含目标检测、实例分割、人脸检测等100+个预训练模型,涵盖多种全球竞赛冠军方案使用简洁: 模块化设计,解耦各个网络组件,开发者轻松搭建、试用各种检测模型及优化策略,快速得到高性能、定制化的算法。端到端打通: 从数据增强、组网、训练、压缩、部署端到端打通,并完备支持云端/边缘端多架构、多设备部署。高性能: 基于飞桨的高性能内核,模型训练速度及显存占用优势明显。支持FP16训练, 支持多机训练。模型性能概览

各模型结构和骨干网络的代表模型在COCO数据集上精度mAP和单卡Tesla V100上预测速度(FPS)对比图。

1.克隆PaddleDetection

由于原始仓库为github链接,下载较慢,可以更换为gitee链接

In [ ]!git clone https://gitee.com/Feng1909/PaddleDetection.git登录后复制

2.安装PaddleDetection的依赖

In [ ]!pip install -r PaddleDetection/requirements.txt登录后复制

3.修改各种参数,如路径等

以训练PPYOLO v2为例

同理可以训练所有PaddleDetection支持的模型

修改数据集路径

PaddleDetection/configs/datasets/voc.yaml

修改为以下路径

metric: VOCmap_type: 11pointnum_classes: 3TrainDataset: !VOCDataSet dataset_dir: ./ anno_path: ./dataset_sample/train.txt label_list: ./dataset_sample/labels.txt data_fields: ['image', 'gt_bbox', 'gt_class', 'difficult']EvalDataset: !VOCDataSet dataset_dir: ./ anno_path: ./dataset_sample/eval.txt label_list: ./dataset_sample/labels.txt data_fields: ['image', 'gt_bbox', 'gt_class', 'difficult']TestDataset: !ImageFolder anno_path: ./dataset_sample/labels.txt登录后复制

4.训练

In [ ]# 从头开始训练,大约需要30分钟# bbox mAP50能达到99.01%!python PaddleDetection/tools/train.py -c PaddleDetection/configs/ppyolo/ppyolov2_r50vd_dcn_voc.yml --use_vdl=true --eval# 中途中断,继续训练,更改output/ppyolov2_r50vd_dcn_voc/248.pdparams为中断前的模型参数# !python PaddleDetection/tools/train.py -c PaddleDetection/configs/ppyolo/ppyolov2_r50vd_dcn_voc.yml -r output/ppyolov2_r50vd_dcn_voc/248.pdparams --use_vdl=true --eval登录后复制

5.模型导出

若需使用TensorRT进行加速,则TestReader.inputs_def.image_shape为必需项目

In [ ]!python PaddleDetection/tools/export_model.py -c PaddleDetection/configs/ppyolo/ppyolov2_r50vd_dcn_voc.yml --output_dir=./inference_model \ -o weights=output/ppyolov2_r50vd_dcn_voc/best_model # TestReader.inputs_def.image_shape=[3,640,640]登录后复制

6.模型部署

参见BITFSD开源3.0

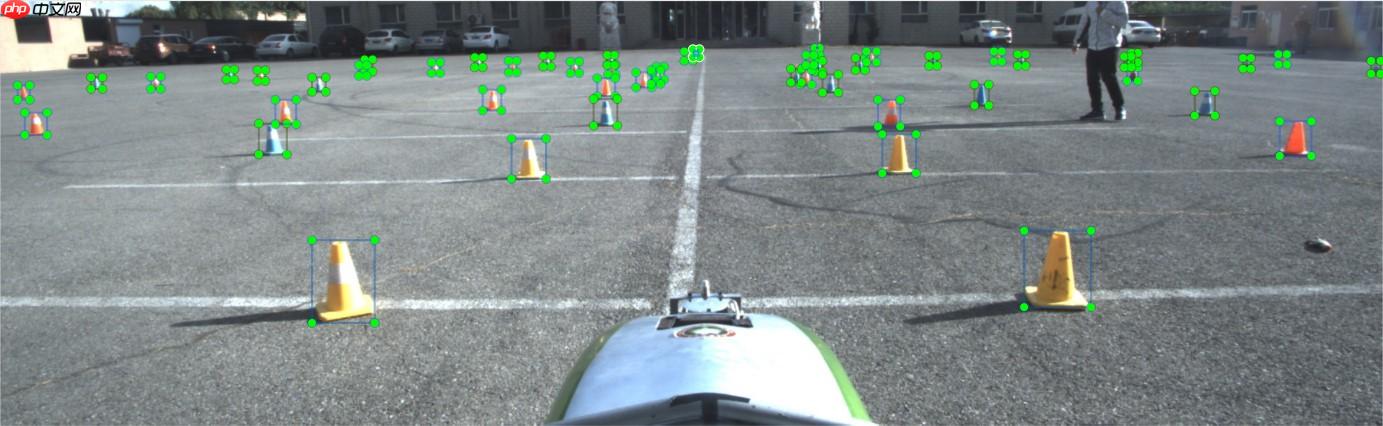

经过完整数据集训练后PPYOLO v2识别效果

方式二 使用PaddleX训练

PaddleX 集成飞桨智能视觉领域图像分类、目标检测、语义分割、实例分割任务能力,将深度学习开发全流程从数据准备、模型训练与优化到多端部署端到端打通,并提供统一任务API接口及图形化开发界面Demo。开发者无需分别安装不同套件,以低代码的形式即可快速完成飞桨全流程开发。

1.安装PaddleX

In [ ]!pip install paddlex==2.1登录后复制

2.设置环境

In [18]# 设置使用0号GPU卡(如无GPU,执行此代码后仍然会使用CPU训练模型)import matplotlibmatplotlib.use('Agg') import osos.environ['CUDA_VISIBLE_DEVICES'] = '0'import paddlex as pdx登录后复制 3.设置数据集增强

In [ ]from paddlex import transforms as Ttrain_transforms = T.Compose([ T.MixupImage(mixup_epoch=-1), T.RandomDistort(), T.RandomExpand(im_padding_value=[123.675, 116.28, 103.53]), T.RandomCrop(), T.RandomHorizontalFlip(), T.BatchRandomResize( target_sizes=[192, 224, 256, 288, 320, 352, 384, 416, 448, 480, 512], interp='RANDOM'), T.Normalize( mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225])])eval_transforms = T.Compose([ T.Resize( target_size=320, interp='CUBIC'), T.Normalize( mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225])])登录后复制

4.设置数据集读取

In [ ]import paddlex as pdxtrain_dataset = pdx.datasets.VOCDetection( data_dir='dataset_sample', file_list='dataset_sample/train.txt', label_list='dataset_sample/labels.txt', transforms=train_transforms, shuffle=True)eval_dataset = pdx.datasets.VOCDetection( data_dir='dataset_sample', file_list='dataset_sample/eval.txt', label_list='dataset_sample/labels.txt', transforms=eval_transforms)登录后复制

5.训练

In [ ]num_classes = len(train_dataset.labels)# model = pdx.det.YOLOv3(num_classes=num_classes)# model = pdx.det.PPYOLO(num_classes=num_classes)model = pdx.det.PPYOLOv2(num_classes=num_classes)model.train( num_epochs=550, train_dataset=train_dataset, train_batch_size=24, eval_dataset=eval_dataset, pretrain_weights=None, learning_rate=0.000125, warmup_steps=100, warmup_start_lr=0.0, lr_decay_epochs=[130, 540], lr_decay_gamma=.5, early_stop=True, save_interval_epochs=20, save_dir='output/ppyolov2', # resume_checkpoint='output/yolov3/epoch_430', use_vdl=True)登录后复制

6.模型导出

若需使用TensorRT加速,则--fixed_input_shape为必需项

In [ ]!paddlex --export_inference --model_dir=./output/ppyolov2/best_model/ \ --save_dir=./inference_model # --fixed_input_shape=[224,224]登录后复制

7.模型部署

参见BITFSD开源3.0

小编推荐:

相关攻略

更多 - WPS表格数据可视化 动态图表制作永久免会员 07.25

- 如何让豆包AI生成代码 豆包AI编程辅助教程 07.25

- 豆包AI如何实现自动化 豆包AI自动化编程指南 07.25

- AI语言转视频结合AI字幕工具实现完整内容自动化 07.25

- 【飞桨论文复现赛-图像描述生成】Soft-Attention 07.25

- ftp扫描工具免费版 ftp扫描工具付费版区别 07.24

- ftp扫描工具命令行 ftp扫描工具图形界面 07.24

- ftp扫描工具集成 ftp扫描工具api接口 07.24

热门推荐

更多 热门文章

更多 -

- 神角技巧试炼岛高级宝箱在什么位置

-

2021-11-05 11:52

手游攻略

-

- 王者荣耀音乐扭蛋机活动内容奖励详解

-

2021-11-19 18:38

手游攻略

-

- 坎公骑冠剑11

-

2021-10-31 23:18

手游攻略

-

- 原神卡肉是什么意思

-

2022-06-03 14:46

游戏资讯

-

- 《臭作》之100%全完整攻略

-

2025-06-28 12:37

单机攻略