o3-mini数学推理暴打DeepSeek-R1?AIME 2025初赛曝数据集污染大瓜

时间:2025-04-22 作者:游乐小编

新智元报道

编辑:编辑部 JHYZ

【新智元导读】刚刚发布的AIME 2025 I数学竞赛大模型参赛结果显示,o3-mini以78%的成绩拔得头筹,DeepSeek R1则以65%的成绩位列第四。然而,一位教授却发现了惊人的事实:一些仅1.5B参数的小模型居然也能达到50%的成绩。这是否意味着数据集存在污染?大语言模型究竟是真正学会了解决数学问题,还是仅仅记住了答案?

关于LLM的「Generalize VS Memorize」之争,近日有了新的进展。

苏黎世联邦理工学院的研究员Mislav Balunović在X上公布了一系列顶级AI推理模型在AIME 2025 I比赛中的表现。

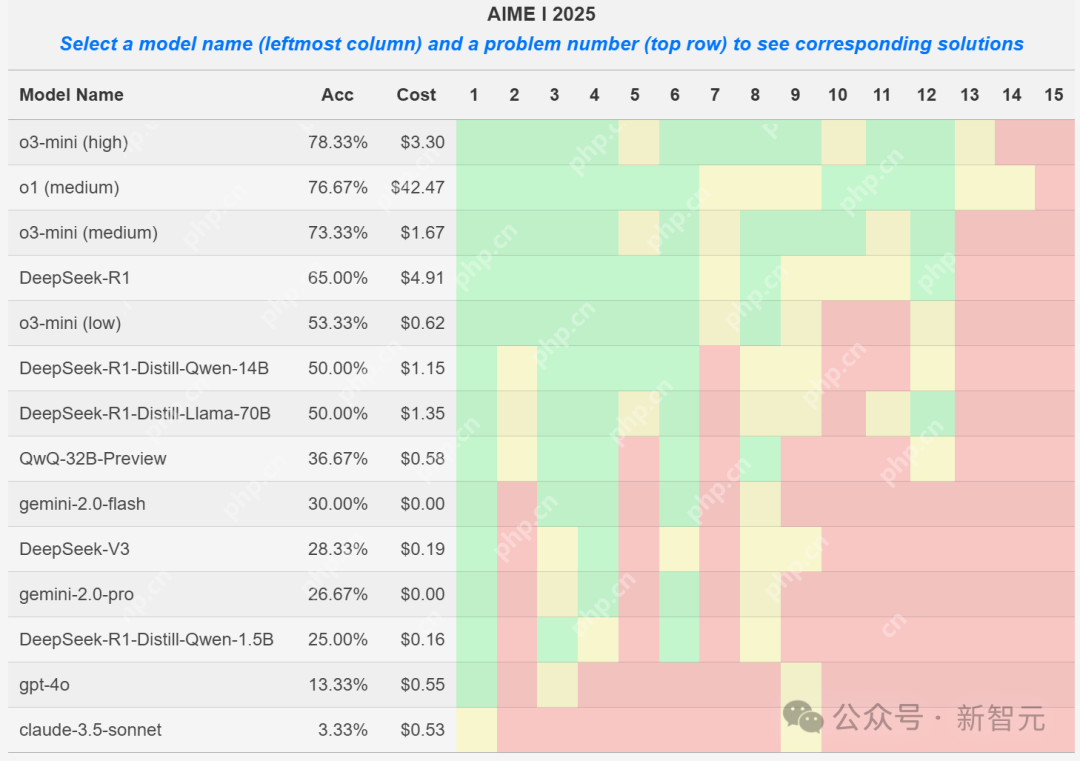

其中,o3-mini (high)以极低的成本解决了78%的问题,令人印象深刻。

其中,o3-mini (high)以极低的成本解决了78%的问题,令人印象深刻。

DeepSeek-R1解决了65%的问题,其蒸馏变体也表现出色,确立了其在开源模型中的领先地位。

图中,绿色代表解答率超过75%,黄色代表解答率在25%-75%之间,红色代表解答率低于25%。

图中,绿色代表解答率超过75%,黄色代表解答率在25%-75%之间,红色代表解答率低于25%。

然而,这些结果是否真的可信?

AI能够解决奥数题,是因为题目已经在网上泄露了吗?

AI能够解决奥数题,是因为题目已经在网上泄露了吗?

威斯康星大学麦迪逊分校的教授,现任微软研究员的Dimitris Papailiopoulos对此结果提出了质疑。

教授对AI模型在数学题上的表现感到惊讶。

教授对AI模型在数学题上的表现感到惊讶。

他原本认为,小型蒸馏模型在面对这些题目时应该表现不佳,没想到它们却取得了25%到50%的分数。

这真是出乎意料!

要知道,如果这些题目是全新的,模型在训练过程中从未见过,那么小模型能拿到0分以上的分数就已经很不错了。

一个1.5B参数的模型连三位数的乘法都做不好,却能解决奥数题,这合理吗?

这不禁让人怀疑其中是否有问题。

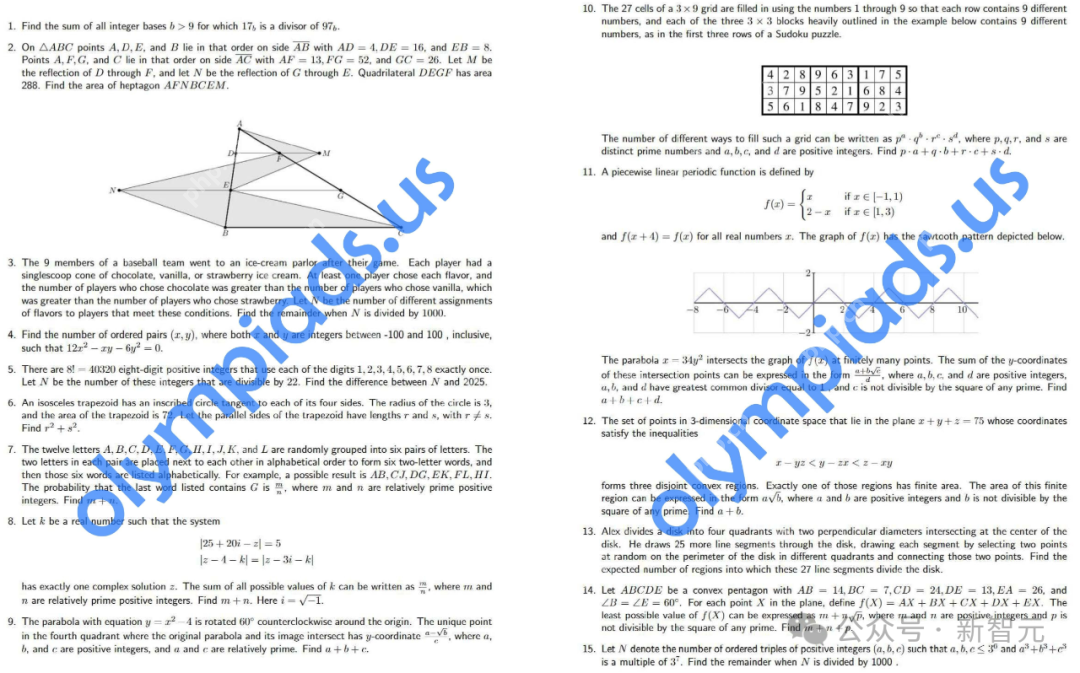

AIME I指的是2025年首场美国邀请数学考试,学生需要在三个小时内挑战15道难题。

AIME I指的是2025年首场美国邀请数学考试,学生需要在三个小时内挑战15道难题。

猜猜发生了什么?

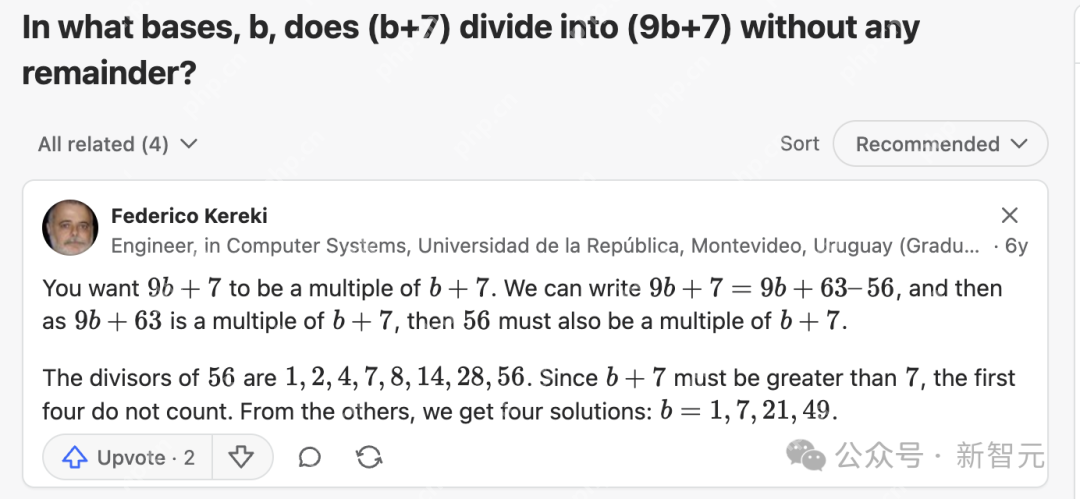

教授使用OpenAI Deep Research进行搜索后发现,AIME 2025的第1题在Quora上已经有了「原题」!

而且这并非巧合,教授再次使用Deep Research查找了第3题,结果在math.stackexchange上找到了一个非常相似的问题:

而且这并非巧合,教授再次使用Deep Research查找了第3题,结果在math.stackexchange上找到了一个非常相似的问题:

仍然感到怀疑的教授,使用DeepResearch继续查找了第7题。

仍然感到怀疑的教授,使用DeepResearch继续查找了第7题。

结果发现,一个完全相同的问题出现在2023年佛罗里达在线数学公开赛的第9题中。

接下来,教授放弃了,因为p值已经低得不能再低。

接下来,教授放弃了,因为p值已经低得不能再低。

他提出了疑问:这对数学基准意味着什么?对RL的快速发展又意味着什么?

教授表示自己并不确定,但他也不排除GRPO(一种强化学习优化策略)在增强模型记忆的同时,也提高了其数学技能的可能性。

至少,这件事表明了一点:数据净化非常困难。

永远不要低估你在互联网上能找到的东西。几乎所有东西都能在网上找到。

网友们也表示,虽然数学奥赛每年都会出新题,但根本无法100%保证之前没有同样的问题出现过。

还有好奇的网友也进行了搜索。

还有好奇的网友也进行了搜索。

其中,第6题似乎有原题,第8题和第10题都有略微相似的题型。

这不禁让人想起OpenAI秘密资助某数据集的旧闻:如果没有特殊目的,为什么不告诉出题的数学家呢?

这不禁让人想起OpenAI秘密资助某数据集的旧闻:如果没有特殊目的,为什么不告诉出题的数学家呢?

难道真如网友Noorie所言「数据去污才是新的Scaling Law」?

什么是MathArena?

什么是MathArena?

MathArena是一个用于评估大模型在最新数学竞赛和奥林匹克竞赛中的表现的平台。

它的核心使命是,对LLM在「未见过的数学问题」上的推理能力和泛化能力进行严格评估。

为了确保评估的公平性和数据的纯净性,研究人员仅在模型发布后进行竞赛测试,避免使用可能泄漏的或预先训练的材料进行回溯评估。

通过标准化评估,MathArena能够确保模型的得分可以实际比较,而不会受到模型提供方特定评估设置的影响。

通过标准化评估,MathArena能够确保模型的得分可以实际比较,而不会受到模型提供方特定评估设置的影响。

与此同时,研究人员会为每个竞赛发布一个排行榜,显示不同模型在各个单独问题上的得分。

此外,他们还将公开一个主表格,展示各个模型在所有竞赛中的整体表现。

为公平评估模型的表现,针对每个问题,每个模型均会进行4次重复评估,最后计算出平均得分以及模型运行成本(以美元计)。

参考资料:

https://www.php.cn/link/ef368049651bc5781718a8d879d9cd24

https://www.php.cn/link/4739d8dbd05dddb73604f6240b83ea68

https://www.php.cn/link/db03d49be7f821909335a60ea7fb7c59

https://www.php.cn/link/ca708d0d44450d9cb93c897bf6515cd3

- 末日生还者Under AI

- 221.57 MB 时间:04.23

小编推荐:

相关攻略

更多 - 电脑开机提示CPU Fan Error的解决方法 05.01

- codeblocks无法编译运行怎么解决 05.01

- Win10系统无法访问D盘提示“位置不可用 拒绝访问 05.01

- yandex账号怎么登录邮箱 账户授权与登录流程详解 05.01

- 解决U盘装系统出现ntldr is missing的方法 05.01

- 电脑开机提示lsass.exe系统错误无法进入系统的解决方法 05.01

- 小编教你怎么使用office2010激活工具 05.01

- 防病毒软件横向评测:卡巴斯基vs火绒vs360 05.01

热门推荐

更多 热门文章

更多 -

- 《哈利波特:魔法觉醒》守护神测试方法攻略

-

2022-09-17 13:04

手游攻略

-

- 大话西游手游冰封幻境最强攻略 冰封幻境解析

-

2022-05-08 21:12

手游攻略

-

- 黑人抬棺材专业团队跳舞

-

2022-07-30 08:06

八卦新闻

-

- 口袋妖怪金手指代码大全

-

2021-12-12 12:51

单机攻略

-

- 《巫师3》妓院升级心得

-

2021-12-16 01:00

单机攻略